Cloud computing, big data, intelligence artificielle … Le développement des nouvelles technologies entraîne une explosion des besoins de stockage des données informatiques et une augmentation exponentielle de la consommation d’énergie des serveurs. Mais aux quatre coins de la planète, des solutions s’échafaudent pour rendre les data centers moins énergivores et réduire leur impact sur les changements climatiques.

Selon une étude menée par l’université de Stanford en 2013, l’ensemble des centres de données en service dans le monde cette année-là mobilisait une capacité de production d’électricité équivalente à celle de 30 réacteurs nucléaires. Sachant que 90 % des données stockées aujourd’hui dans les serveurs ont été produites au cours des deux dernières années, les ressources énergétiques nécessaires se sont certainement encore fortement accrues.

Sur les disques durs, le transfert de données se fait par des têtes magnétiques. Une opération qui met en jeu des courants électriques relativement élevés et entraîne donc une importante consommation d’énergie. En fin de compte cette énergie se dissipe sous forme de chaleur. Pour éviter qu’une surchauffe ne provoque des dégâts aux machines, les salles informatiques et data centers doivent donc être réfrigérés en permanence. Ceci se fait traditionnellement par des groupes frigorifiques qui soufflent de l’air froid dans les locaux. Mais nous comprenons bien qu’un tel conditionnement d’air est à son tour responsable d’une aggravation de la facture énergétique et de l’impact écologique de ces installations.

Face à la croissance exponentielle de leurs coûts énergétiques les géants de l’informatique mais aussi des sociétés plus modestes ont dès lors envisagé des solutions alternatives.

Ainsi, dans l’un des stockages de données de Google construit en 2007 à Douglas en Géorgie (Etats-Unis), le système de refroidissement était au départ alimenté tout simplement par le réseau d’eau de la ville. Mais l’entreprise s’est vite rendue compte que le liquide réfrigérant ne devait pas forcément être potable. Elle a donc conclu un accord avec la municipalité pour utiliser les eaux des égouts. L’air chaud généré par les serveurs passe dans un échangeur où il cède sa chaleur aux eaux usées dont une partie s’évapore dans une tour de refroidissement semblable à celles que l’on voit dans les centrales électriques. Ensuite le reste des eaux souillées est traité et désinfecté par Google avant d’être rejeté dans la rivière. C’est ce que l’on appelle une opération gagnant-gagnant : pour la collectivité d’abord puisqu’une partie du traitement des eaux sales est financée par Google et que l’entreprise ne prélève plus d’eau potable. Et pour le géant de l’internet la facture du refroidissement de ses serveurs s’est nettement allégée.

Google a été plus loin pour un autre data center implanté en Finlande, dans une ancienne papeterie située au bord de la Baltique. Là c’est tout simplement l’eau de mer qui est utilisée pour réfrigérer les ordinateurs. HP et Facebook exploitent des solutions équivalentes : le premier en refroidissant ses salles informatiques avec de l’eau de pluie et le réseau social en installant un centre à Luleå dans le nord de la Suède où le réfrigérant utilisé est tout simplement l’air froid extérieur.

D’autres idées sont exploitées un peu partout dans le monde, notamment en France où la zone industrielle du Futuroscope héberge plusieurs Data Centers « propres ». Comme par exemple celui de la société Cyberscope qui propose des offres d‘éco-hébergement. Son data center « troglodyte » est semi-enterré, la chaleur produite par les serveurs étant utilisée en hiver pour chauffer le bâtiment. En été, les salles informatiques sont rafraichies par de l’air extrait d’un puits canadien (creusé dans le sol).

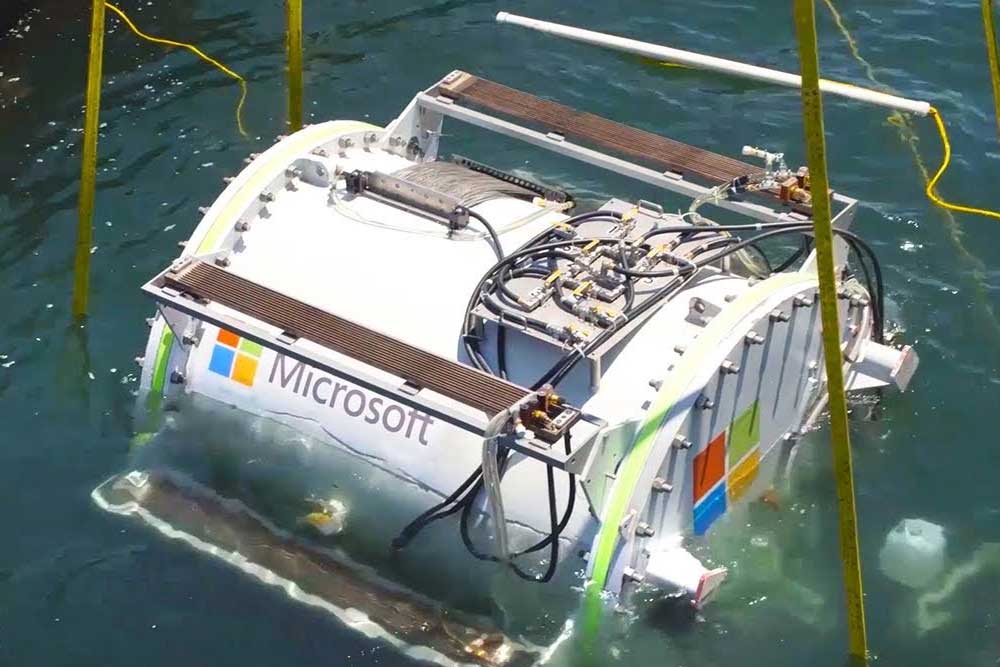

Le concurrent Microsoft est encore plus inventif quand il étudie la possibilité de plonger ses data centers dans la mer. Un premier prototype, baptisé Leona Philpot et pouvant opérer à quelques centaines de mètres sous l’eau, a été testé pendant plusieurs mois. La société de Redmond cherche à établir les bénéfices et difficultés qu’il pourrait y avoir à immerger sous la mer ce type d’implantation. En eaux profondes, le refroidissement est naturel. En outre les exploitants des centres de données essayent de se rapprocher des utilisateurs. Or près de la moitié des populations habitent dans une zone située à 200 km d’une côte.

Tous ces projets offrent certes l’avantage d’une réduction de la consommation d’énergie utilisée pour le refroidissement des serveurs. Mais, malheureusement, la chaleur produite n’est pas exploitée.

Mise à l’eau du data center sous-marin de Microsoft

Stockholm utilise les data centers comme source d’énergie

Résolue à jouer un rôle de pionnier dans la lutte contre les changements climatiques, Stockholm capitale de la Suède, projette de réduire à zéro l’utilisation d’énergies fossiles d’ici 2040. Pour atteindre cet objectif, la ville a notamment lancé un projet visant à rendre les centres de données plus durables.

Le Stockholm Data Parks se veut une version nordique de la Silicon Valley : une plate-forme « écolo » pour le stockage des données d’entreprises et de start-ups technologiques. Ces sociétés sont alimentées en électricité par des éoliennes, des centrales hydroélectriques et des installations solaires. Mais la capitale scandinave veut aussi utiliser la chaleur produite par tous ces serveurs pour chauffer ses bâtiments. L’un des partenaires du projet, Fortum Värme, possède plus de vingt-cinq ans d’expérience en matière de réseaux de chaleur. Le parc de data centers de Stockholm alimentera donc un vaste complexe d’immeubles.

Espérant produire 10% de son énergie avec la chaleur résiduelle des centres de données Stockholm entend évidemment être attractive pour ces entreprises. Désormais celles-ci profitent d’une réduction du taux d’imposition ce qui leur permet de payer le tarif le plus bas jamais pratiqué dans l’UE pour l’électricité qu’elles consomment. En outre les data centers produisant au minimum 10 MW de chaleur résiduelle – assez pour chauffer quelque 20.000 habitations modernes – ne doivent rien débourser pour le refroidissement de leurs machines.

Pour se passer totalement des énergies fossiles, Stockholm entend utiliser la chaleur de data centers pour chauffer ses bâtiments

Un nouveau matériau nanoporeux

Si l’on parvenait à réduire les champs magnétiques et les courants électriques mis en œuvre pour transférer des données sur les disques durs, on pourrait augmenter le rendement énergétique et réduire encore les consommations des serveurs informatiques. Ce serait possible en diminuant la puissance de champ nécessaire pour réduire l’induction magnétique du matériau utilisé. Une recherche financée par l’UE permet d‘espérer une solution. L’équipe du projet SPIN-PORICS a récemment annoncé avoir créé les premiers prototypes de mémoires magnétiques nanoporeuses à partir d’alliages de cuivre et de nickel. Selon le professeur Jordi Sort, coordinateur du projet, « les nanopores présents à l’intérieur des matériaux nanoporeux permettent de disposer d’une surface importante concentrée dans un très petit espace. Nous pouvons leur appliquer la tension d’une pile et réduire considérablement l’énergie requise pour enregistrer les données. Ce nouveau concept peut contribuer à réduire l’énergie consommée par les ordinateurs, l’informatique et le traitement des données magnétiques en général ».

Il faudra toutefois patienter quelques années avant que cette recherche ne débouche sur des réalisations industrielles. En attendant de voir arriver des serveurs moins énergivores dans les data centers, Stockholm pourra donc les utiliser encore quelque temps pour se chauffer.

Un article intéressant pour compléter celui-ci:

https://lejournal.cnrs.fr/articles/numerique-le-grand-gachis-energetique

Le titre (hormis le dernier paragraphe) ne reflète pas le contenu de l’article. Il n’y a pas de réduction de consommation, mais une meilleure exploitation de l’énergie dissipée et une consommation d’énergie plus propre. C’est au moins le cout d’exploitation que ces centres cherchent à réduire.

Pas vraiment d’accord avec vous. En refroidissant les serveurs avec l’eau des égouts ou l’eau de mer au lieu de souffler de l’air froid fourni par des groupes frigorifiques cela engendre une réduction de consommation importante. Certes pas optimale : il vaut mieux utiliser la chaleur pour chauffer des bâtiments plutôt que la dissiper dans la rivière ou la mer et il vaut encore mieux engendrer moins de chaleur en mettant au point des nouvelles technologies, mais c’est justement cette gradation dans la recherche de solutions optimales que l’article explique. Je pensais que ce serait assez clair et que tout… Lire plus »

Moi j’avais compris, rassurez-vous :o)

Je pense qu’il faut se méfier des solutions soit disant écolo ou l’on refroidie les data center avec l’eau de mer ou l’eau d’une rivière. Car il ne faut pas que l’eau rejetée soit plus chaude que l’eau aspirée.

Tout à fait juste, c’est pour cela qu’il faut plutôt ré-utiliser la chaleur produite (chauffer des bâtiments, faire de l’électricité, etc), ou encore mieux diminuer la quantité de chaleur générée. Mais refroidir avec de l’eau de mer ou de rivière est une fausse bonne idée.

La chaleur produite pourrait faire de l’électricité avec l’invention d’Arabie Saoudite quand développée ? Mais…, où ais-je fous-tue le lien ?